基于RGB的图像数据增强

基于 RGB 的 Lidar 数据增强

Sparse-to-Dense: Depth Prediction from Sparse Depth Samples and a Single Image 从稀疏到密集:从稀疏深度样本和单一图像的深度预测

motivation

由于仅从单眼图像进行深度估计本质上是模糊和不可靠的,为了获得更高水平的鲁棒性和准确性,引入了额外的稀疏深度样本,使用单一的深度回归网络直接从RGB-D原始数据中学习

methodology

网络架构 > CNN 编码器+解码器(encoder+decoder)

不同的数据集需采用不同的网络架构

损失函数 > L1范数

Depth Estimation via Affinity Learned with Convolutional Spatial Propagation Network 利用卷积空间传播网络(CSPN)进行深度估计

motivation

采用了一种线性传播模型,其中传播以递归卷积操作的方式进行,并通过深度卷积神经网络(CNN)学习相邻像素之间的亲和性。

methodology

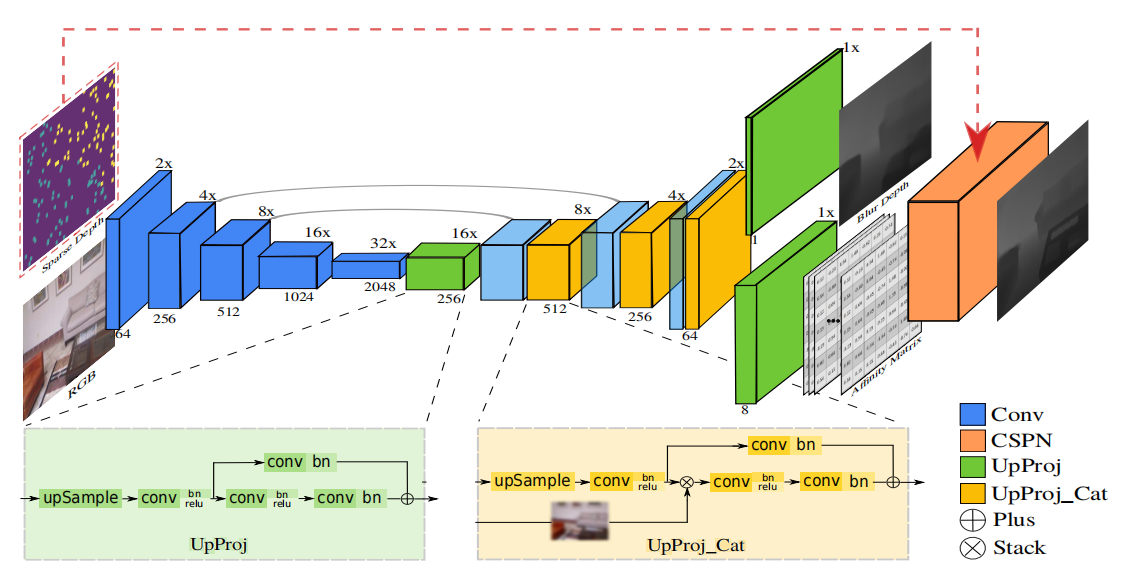

网络架构——卷积空间传播网络 CSPN > 输入:RGB图和稀疏深度 输出:稠密深度图

对给定网络的额外输出进行分支,它与深度网络共享相同的特征提取器。

损失函数 > 参考上篇论文采用L1范数

Sparse and noisy LiDAR completion with RGB guidance and uncertainty 利用RGB完成对稀疏含噪雷达信号的重建

motivation

在RGB图像引导下精确完成稀疏激光雷达映射。从映射到二维平面的稀疏和不规则的点云中生成密集的深度预测。 KITTI上排名第一(2019)。

methodology

将深度补全问题作为一个回归问题来处理。

有监督:需要ground truth,将缺失的激光雷达输入值编码为0。

利用全局和局部信息来完成输入。

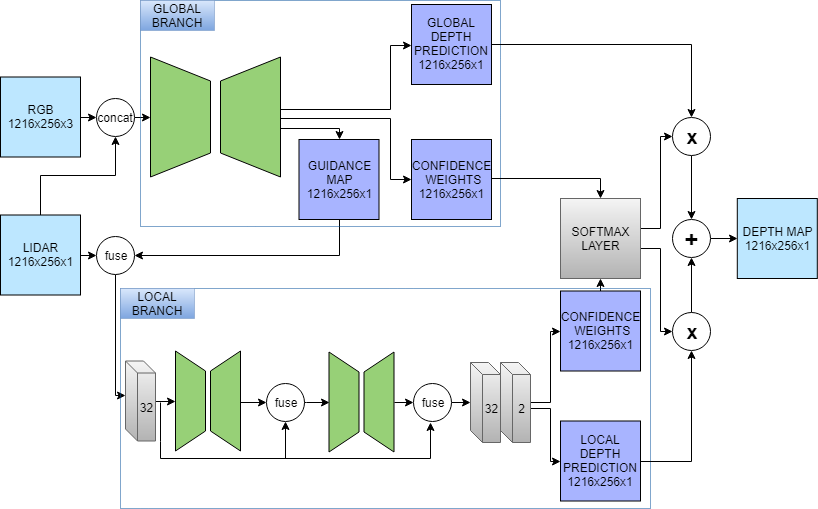

局部网络将解释局部信息,而全局网络则基于激光雷达和RGB信息提取全局信息。这两个网络之间的融合产生了最终的深度图。

全局分支可以看作是一个先验,即regulize由局部路径提取的特征。

首先,全局网络能够检测到(移动的)物体,并能够检测到一帧中可能具有相同深度的结构。我们期望计算得到一个更渐进的深度图,以防止激光雷达输入的突然变化和错误。这些信息可以通过检查RGB输入来确定,因为由于对象的颜色信息,可以更容易地提取对象的边界。因此,可以提取出语义上有意义的信息。

局部网络的输入为激光雷达帧,并执行局部上采样。为了修正有噪声的激光雷达数据,我们将激光雷达图与全局RGB图融合在一起。

网络结构

网络结构全局网络是一个基于ERFNet的编解码器网络,而局部网络是一个堆叠的沙漏网络。

局部网络由两个沙漏模块组成,以学习原始深度预测上的残差。

一方面,全局网络提供了三种输出图:带有全局信息的引导图、深度图和置信图。另一方面,局部网络提供了一个深度图和一个置信图。通过将置信图与其深度图相乘,并添加来自两个网络的预测,从而得到最终的预测。置信图的概率值是利用softmax函数计算的。

利用网络中的不确定性

在具有精确和足够的激光雷达点的位置,局部网络将产生高置信度的深度预测,而在激光雷达数据不正确或稀缺时,将使用全局信息,例如在物体的边界。