换脸技术论文归纳(2022.12)

FaceShifter:

Towards High Fidelity And Occlusion Aware Face

Swapping

FaseShifter:高保真、遮挡识别换脸技术

2020-09-15 Lingzhi Li等 pkuµsoft

研究目的以及针对问题

高保真度以及遮挡识别的人脸换脸技术。

高保真度

合成的人脸不仅共享目标面孔的姿态和表情等 属性 (attributes),而且可以 没有违和感 地嵌入目标图像:

- 换脸后人脸的渲染应保留目标场景的 光照 信息(例如方向、强度、颜色等);

- 换脸后人脸的 像素分辨率 也应与目标图像分辨率一致。

面部遮挡

能够针对一些异常遮挡的类型识别,如眼镜、阴影和反射效应以及其他不常见的遮挡。

所提方法

此方法需要两张输入图像,即一张源图像

所提出的FaceShifter分为两个阶段:

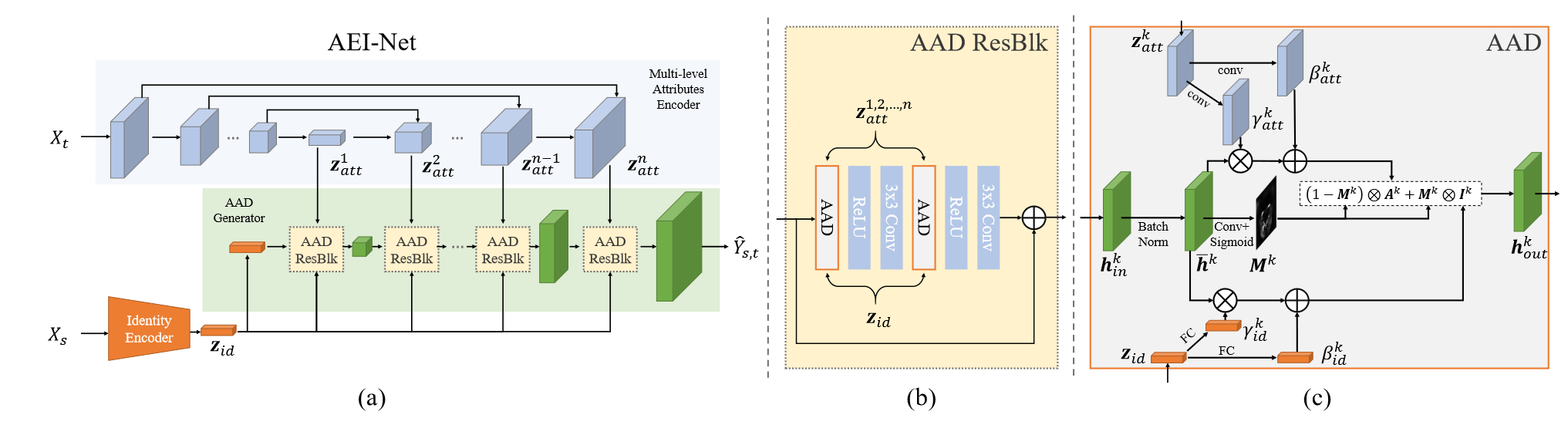

自适应嵌入集成网络(Adaptive Embedding Integration Network,AEINet)

在第一阶段,我们希望生成一个高保真(拥有源图像

i)身份特征编码器

ii)多级属性编码器

该属性嵌入网络不需要任何属性标注,它通过自监督训练来提取属性。

iii)自适应注意去正常化生成器(Adaptive Attentional

Denormalization Generator,AAD-Generator)。整合

损失函数

采用对抗训练的方式训练AEI-net。令对抗损失为

i)身份信息损失

ii)属性信息损失

iii)当训练样本中的源图像和目标图像相同时,定义重建损失

AEI-Net 最终使用上述损失的加权和进行训练。

启发式误差确认精确化网络(Heuristic Error Acknowledging Network,HEARNet)

解决问题:AEINet虽然可以很好地保留目标属性,但往往无法保留目标人脸上出现的遮挡。

当目标面部被遮挡时,一些遮挡可能会在交换后的面部消失。同时,我们观察到,如果我们将与源脸和目标人脸相同的图像输入到训练好的 AEI-Net 中,这些遮挡也会在重建图像中消失。因此,可以利用 重建图像与其输入之间的误差 来定位面部遮挡。

结论

第一阶段的 AEI-Net 自适应地整合身份和属性以合成高保真结果。第二阶段的 HEAR-Net 以自监督的方式恢复异常遮挡区域,无需任何手动注释。该框架在给定任何人脸对而无需特定主题训练的情况下,在生成逼真的人脸图像方面表现出卓越的性能。

HifiFace:

3D Shape and Semantic Prior Guided High Fidelity Face Swapping

HifiFace: 3D形状和语义先验指导的高保真人脸交换

2021 Yuhan Wang等 zju&Youtu Tencent

研究目的以及针对问题

为了生成高保真的面孔交换结果,有几个关键问题:

(1)结果面孔的身份(包括面孔形状)应该接近源面孔。

(2)结果应具有真实感,忠实于目标人脸的表情和姿态,目标图像的细节如光照、背景、遮挡等一致。

所提方法

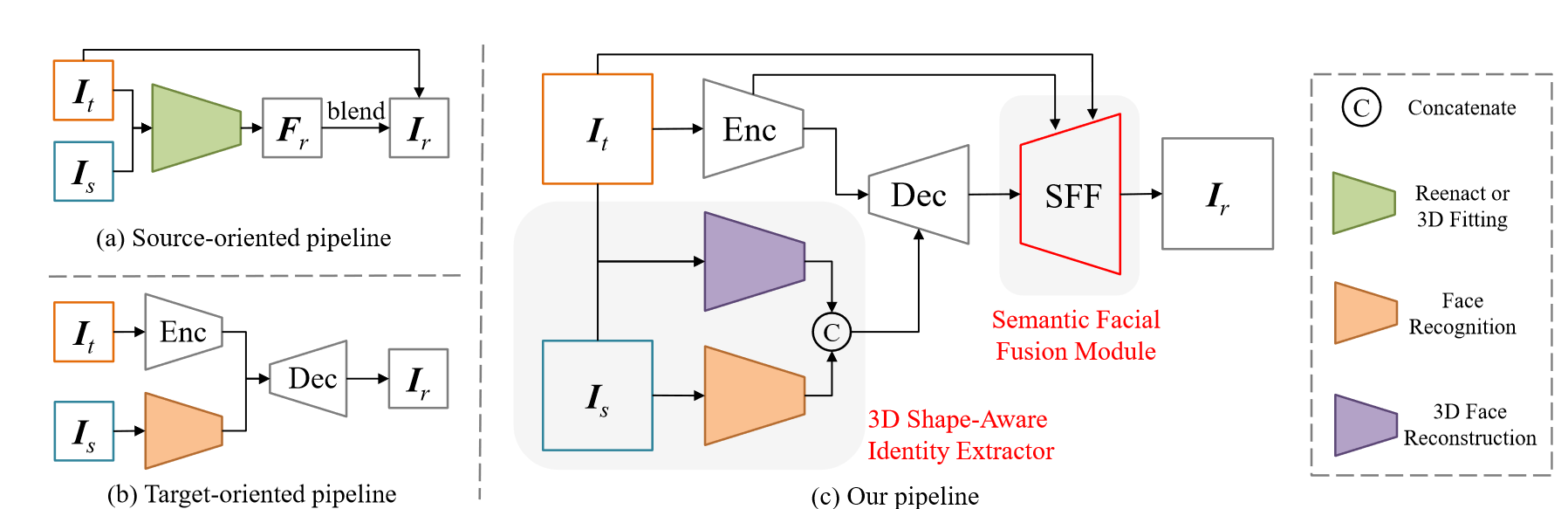

此方法由四个部分组成:编码器部分、解码器部分、3D形状感知身份提取器(3D Shape-Aware Identity Extractor)和SFF模块(Semantic Facial Fusion Module)。编码器提取特征,解码器融合编码器特征,3D形状感知身份特征。最后,SFF模块有助于进一步提高图像质量。

3D形状感知身份提取器(3D Shape-Aware Identity Extractor)

大多数基于GAN的方法在人脸交换任务中仅使用人脸识别模型来获取身份信息,这种模型更侧重于纹理, 对 几何结构 不敏感。为了得到更精确的人脸形状特征,我们引入 3DMM ,并使用预训练的最先进的3D人脸重建模型作为形状特征编码器。

3D形状感知身份提取器使用

语义面部融合模块(Semantic Facial Fusion Module,SFF模块)

- 特征级别

如上图(b)所示,SFF模块通过

此法提出的SFF模块,既充分利用了低层编码器和解码器特征,又克服了低层编码器特征中由于目标的身份信息而损害身份的矛盾。

当解码器特征

其中

在特征级融合之后,我们生成

- 图像级别

此方法使用SFF来学习一个视觉上扩张的轮廓,并接受人脸形状的变化。具体来说,我们预测一个3通道的

损失函数

3D Shape-Aware Identity (SID) Loss.

SID损失为形状损失和身份损失的加权和。

Realism Loss.

真实感损失包括分割损失、重建损失、循环损失、感知损失和对抗损失。

结论

提出了一种 3D形状感知的身份提取器 来帮助保留包括人脸形状在内的身份。

提出了 SFF模块 ,更好地实现了特征级和图像级的结合,用于颇具真实感的图像生成。

InfoSwap:

Information Bottleneck Disentanglement for Identity

Swapping

用于身份交换的信息瓶颈解耦

2021 Gege Gao等 中科院自动化所

研究目的以及针对问题

恰当的 解耦 是很好地表征身份和知觉信息的必要前提。否则,纠缠的目标感知必然会将目标身份带入合成过程,导致结果人脸身份混合。

主要思想是从预训练模型的潜在特征中学习关于身份和身份无关感知信息的最小充分统计量,即 最优表示。将这一学习过程建模为一个优化信息瓶颈( Information Bottleneck,IB )权衡的问题。基于IB原理,我们可以为解耦表示学习提供显式监督。

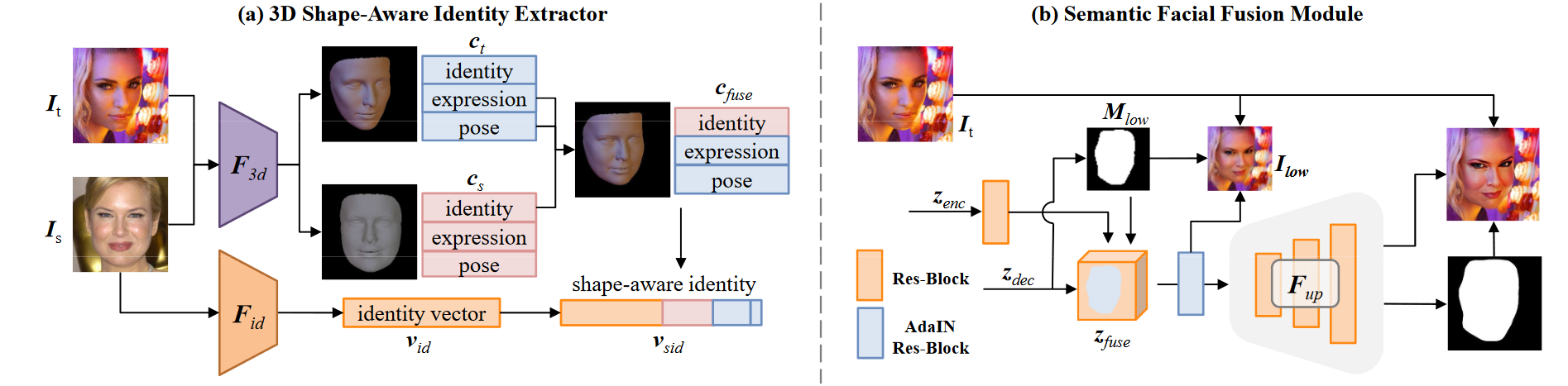

所提方法

InfoSwap 由两个可学习模块组成,一个 信息身份瓶颈

(蓝色)和一个 自适应信息集成器

(棕色),而预训练人脸识别网络(绿色)是固定的。

换脸中的区别身份

为了使生成的身份具有高区分性,避免目标感知将目标身份信息带入合成过程至关重要。因此,此模型旨在改善信息解耦并生成具有区别身份的换脸。

信息身份瓶颈

直觉 与 IB 原则

根据信息论的观点,深度学习的目标被解释为寻找输入源

在换脸任务中,目标是学习关于身份的最具表现力的表征R,同时最大限度地压缩其中与身份 无关的感知信息。通常,我们将这样的学习过程视为一个信息瓶颈权衡优化问题。通过最小化下面的目标函数来优化这个权衡:

基于IB目标函数的解耦

优化过程在IIB中进行。为了分离每个内部特征Ri中的身份和感知信息,每个瓶颈

对信息压缩进行监督

对潜空间的监督

对像素空间的监督n引入了另一种监督

- 自适应信息集成

由于

损失函数

- 对抗损失

- 感知损失

- 循环一致性损失

结论

在本文中,我们提出了InfoSwap来学习解耦表示。通过将学习过程建模为基于信息瓶颈原理寻找预训练的潜在特征的最优压缩,有效地分离了身份和感知信息的提取表示。我们借助对比学习的直觉对IB目标进行了扩展,使我们能够生成区别身份的换脸。

MegaFS:

One Shot Face Swapping on Megapixels

百万像素级的单镜头换脸

2021 Yuhao Zhu等 中科院自动化所

研究目的以及针对问题

完整的人脸表征、稳定的训练和有限的内存使用。

由于存在以下问题,生成高分辨率互换人脸比较困难:

首先,由于端到端框架中的压缩表示,信息不足以生成高质量的人脸。

其次,对抗训练不稳定,限制了以往方法的分辨率只能达到

第三,GPU内存限制使得训练无法持续,或者训练批次被小尺寸所限制,加剧了训练过程的崩溃。

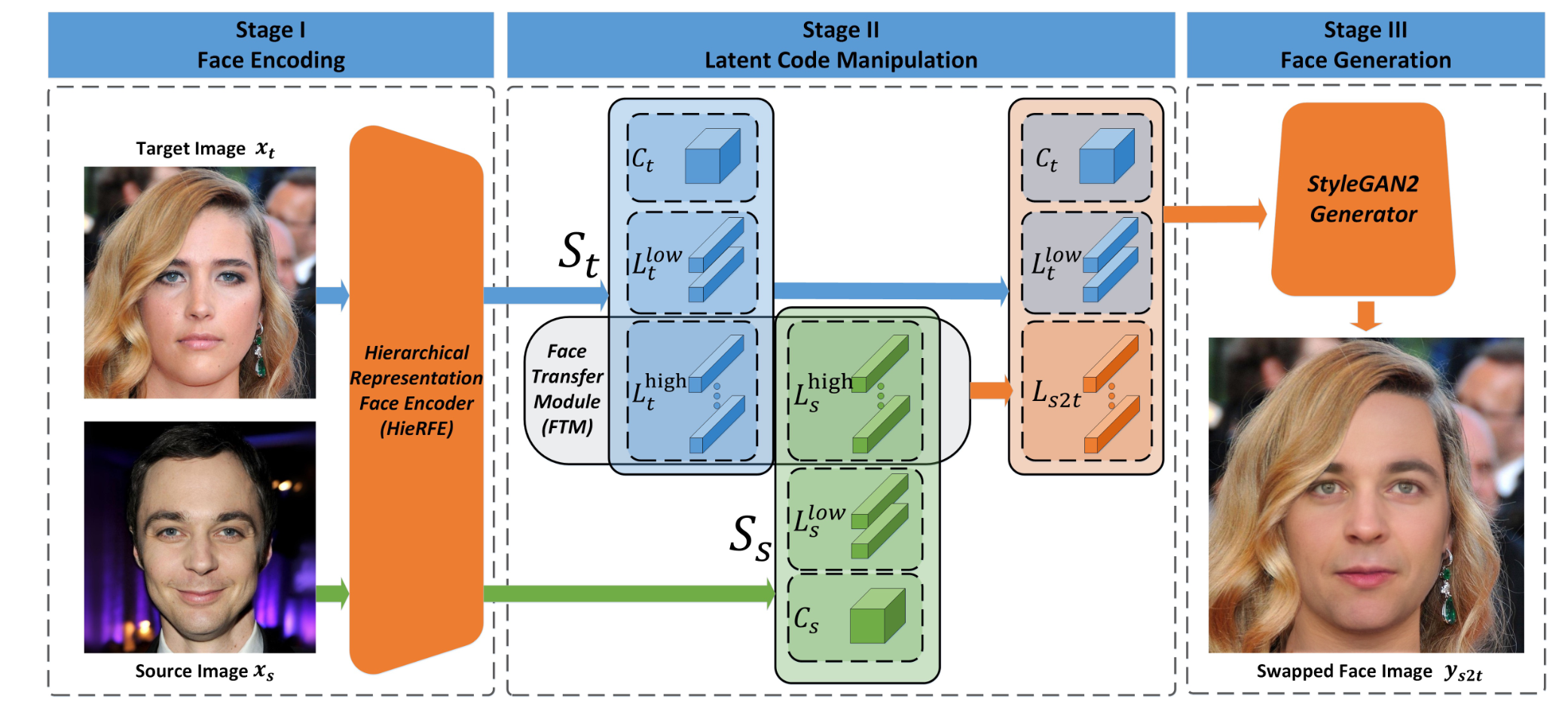

所提方法

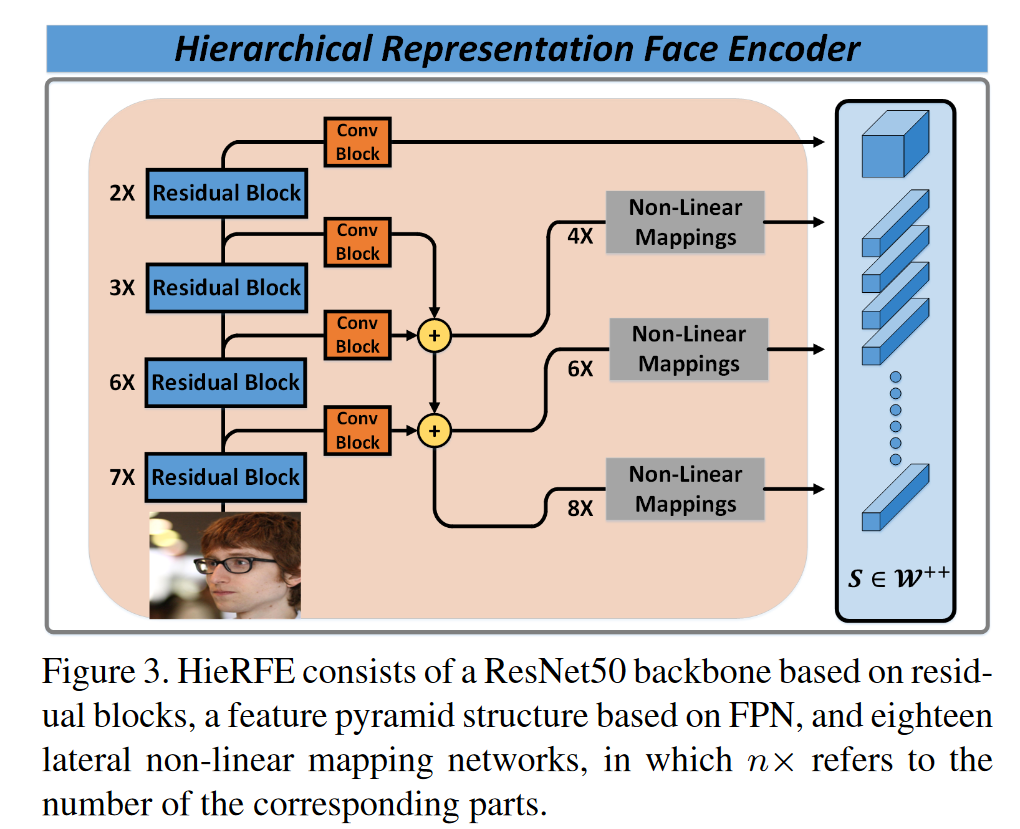

人脸的分层表示

在第一阶段,使用分层表示人脸编码器( Hierarchical Representation Face

Encoder,HieRFE )将人脸图像投影到潜空间

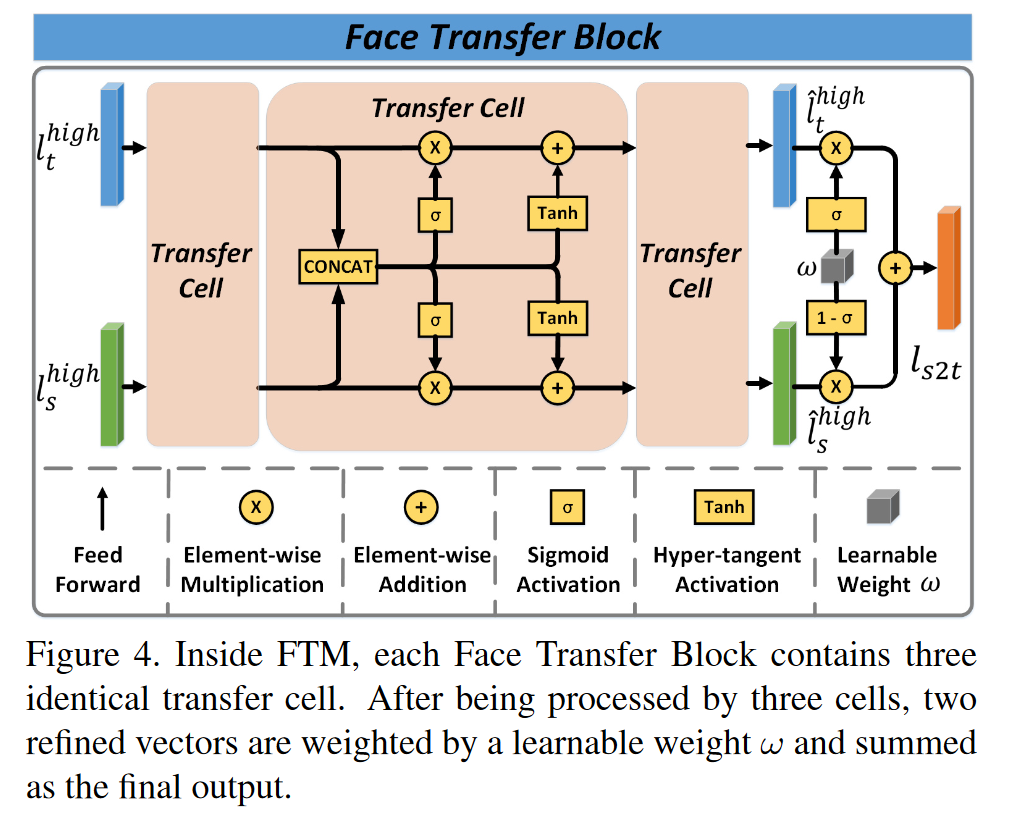

多属性的同步控制

在第二阶段,提出了人脸转移模块( Face Transfer Module,FTM

),以同步的方式控制身份信息的多个属性以满足面孔交换需求。其中,FTM包含14个Face

Transfer Block,其数量等于

高保真人脸生成

最后在第三阶段,由于

通过使用StyleGAN2作为解码器,区别于其他的人脸交换框架的是, 通过潜空间进行换脸。

首先,它为完整的人脸表示提供了一个扩展的潜在空间,使得详细的人脸生成成为可能。

其次,它使我们的方法在

第三,不需要显式的属性解耦,使得训练过程简单,无需复杂的损失函数和超参数设置。

目标函数

HieRFE和FTM被依次训练,而StyleGAN2生成器保持不变。

HieRFE的目标函数

FTM的目标函数

结论

第一阶段的 HieRFE 在扩展的潜空间中进行 分层表示,以实现完整的面部信息存储。

第二阶段的 FTM 通过非线性轨迹将源图像中的身份信息传递给目标,无需显式的特征解缠。

最后,使用StyleGAN2合成交换人脸,避免不稳定的对抗训练。

StyleSwap:

Style-Based Generator Empowers Robust Face

Swapping

Styleswap:基于Style的生成器支持鲁棒的人脸交换

2022 Zhiliang Xu等 百度

研究目的以及针对问题

仅提供单帧图像作为源图像,但针对不同类型的场景时的人脸交换非常困难。

其中关键的挑战在于两个重要的部分:

如何 显式地捕获身份信息;

如何在保持隐式属性不变的情况下,将交换后的人脸无缝地融合到目标中。

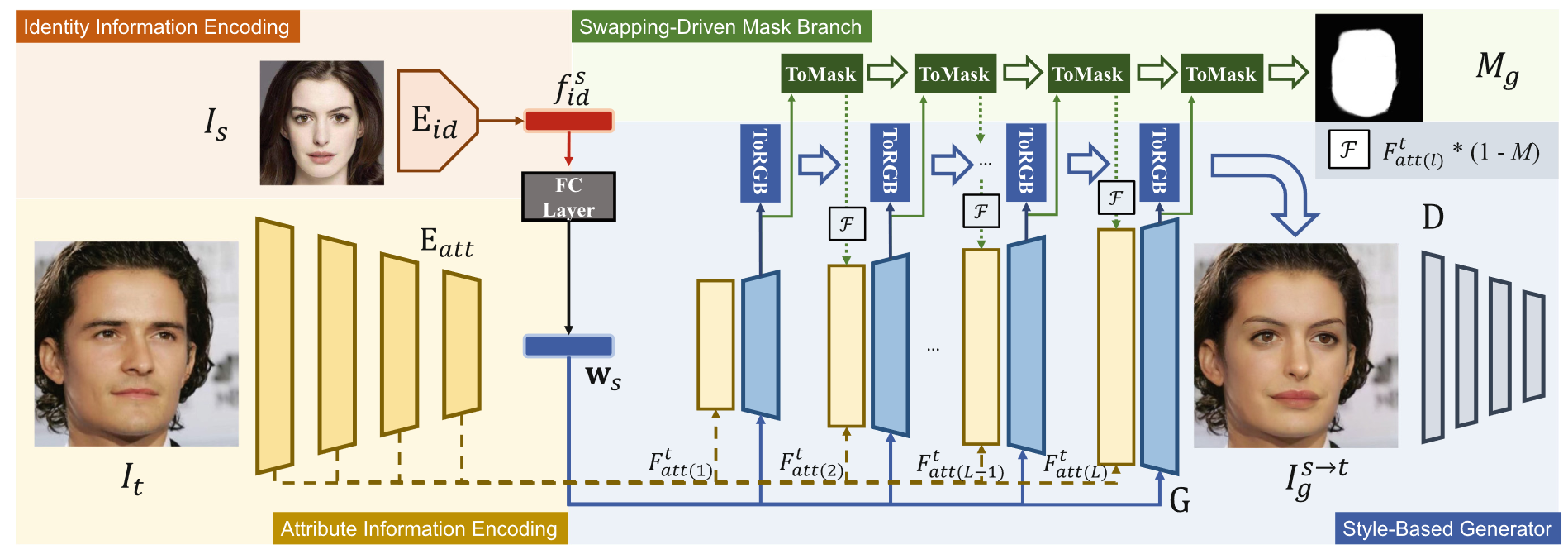

所提方法

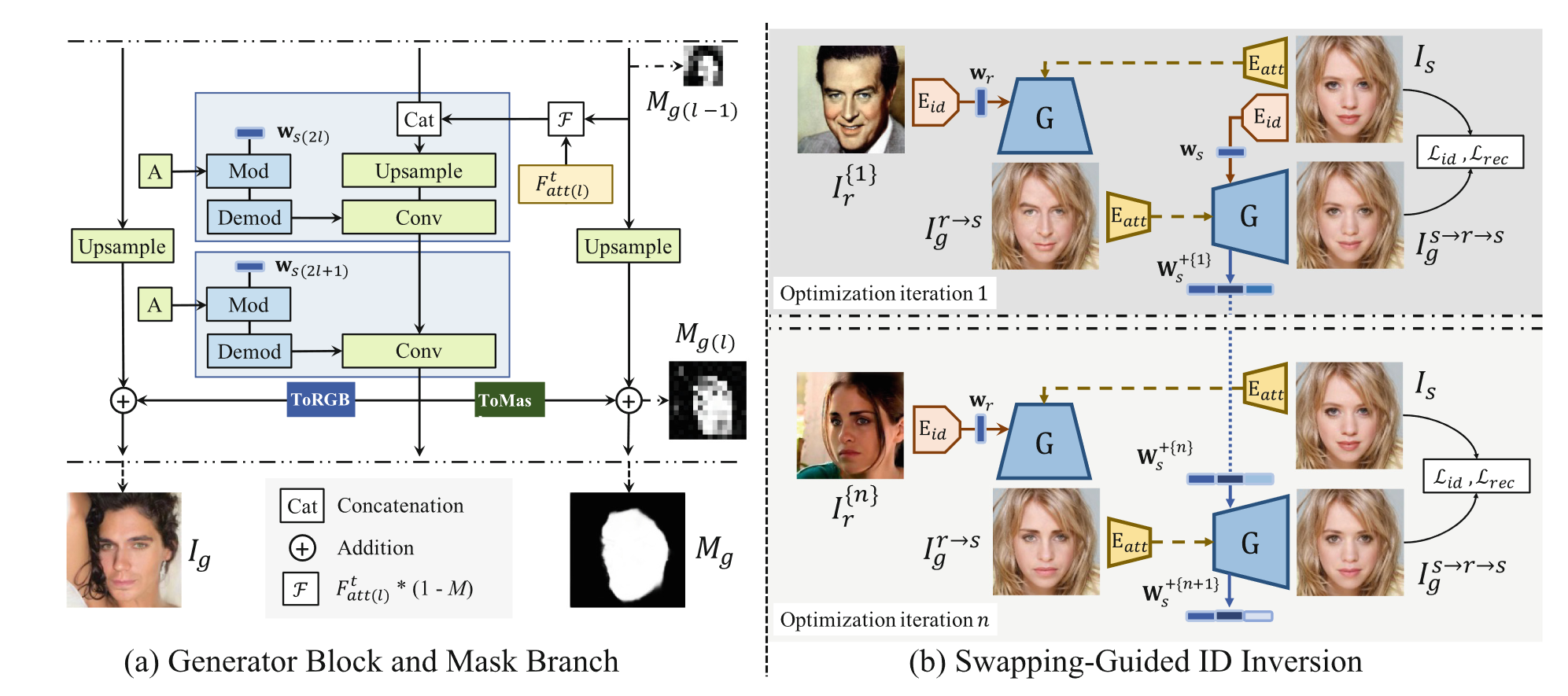

基于Style的生成器 用于 换脸

回顾 StyleGAN2.

原始生成器在最低分辨率下取一个恒定的特征图,然后采样一个潜在向量z并映射到一个特征向量w (位于W空间)。然后,通过仿射变换将 w 作为 style 送入2L层生成器的每一层,以调节卷积核的权重。在每个分辨率下,设计一个ToRGB层来渐进地渲染三通道RGB图像。

StyleGAN2中的属性解耦能力是在W或扩展的W +空间(如果将不同的w特征馈送到不同的层)中隐式实现的。因此,对现有人脸的操作需要将人脸反转为潜在向量,这不利于空间信息的保存。在此研究中,问题在于如何修改生成器,使得目标框架和身份的信息能够被充分利用。

注入属性信息。

我们提出将目标的空间信息融合为特征图,而不是特征向量,以保留属性信息。

将噪声图串联到生成器的每一层不会影响网络的生成能力。

这样的噪声图可以被编码的空间特征图代替,这样既可以保留StyleGAN2模型的生成先验,又可以保留输入图像的结构信息。

注入身份特征。

将身份信息编码为特征向量。使用ArcFace的预训练身份编码器对身份特征进行编码。

通过全连接层直接将身份特征映射到W空间中的

换位驱动的掩膜branch。

从两个角度确定学习一个粗糙的单通道掩膜将有利于整个换脸步骤。

1 )在图像域使用掩膜,不需要修改的区域如背景和头发可以直接保持不变。

2 )如果掩膜可以随着生成器逐步地、隐式地学习,那么较低分辨率的粗掩膜可以帮助平衡属性和身份信息。

因此,我们提出了一个额外的修改,设计一个交换驱动的掩膜分支。其结构直接借用'ToRGB'分支,记为' ToMask ',使用一个取值在0到1之间的软掩膜。

屏蔽属性信息。

中低层提供的空间信息可能会影响面部结构。

尽管我们期望网络自动地执行信息平衡,但我们发现这个过程可以通过依赖一个隐式学习的掩膜来阻止属性信息。因此,我们将每个分辨率下的学习掩膜与下一层的属性特征图相乘。这样,随着掩膜逐渐增长到ground truth掩膜,它也隐式地阻止了属性信息对身份相似性的影响。

损失函数

身份损失

对抗损失和特征匹配损失

重建损失

掩膜损失

换脸引导的身份反转

身份相似度可以通过一种 换脸引导的身份反转 策略以 GAN反演 的方式进行优化,而生成器是固定的。

- 迭代的身份优化和交换。

此方法的关键是 在优化过程的每一次迭代中 给源图像输入一个不同的脸。具体来说,在每次迭代n时,随机采样任意人脸来更新源帧上的身份信息,使网络感知不同的身份。

结论

StyleSwap是一个简洁有效的框架,它采用基于style的生成器进行高保真的人脸交换。我们强调了该方法的几个关键特性:

1 )我们的方法只需对StyleGAN2生成器进行少量修改,易于实现且训练友好,节省了大量的人力劳动。

2 )利用基于风格的生成器的强大能力和交换引导掩膜分支的简单设计,我们的结果不仅具有高质量、相似性而且具有很高的鲁棒性。

3 )我们的方法可以利用GAN反演的优势,优化

4 )我们的方法可以通过提供逼真的伪造结果来帮助人脸伪造检测。